Bağlamda:Sektörde hiç kimse Nvidia’nın ürünlerine aşırı güvenmeyi sevmiyor, ancak birçok şirket Team Green’in AI çiplerinin baskın tedarikçisi olması nedeniyle başka bir seçenekleri olmadığını düşünüyor. Ancak Apple farklı bir yol izledi ve sonuçlardan memnun görünüyor: büyük dil modellerini eğitmek için Google’ın TPU’larını tercih etti. Bunu biliyoruz çünkü Cupertino, Apple Intelligence özelliklerini geliştirmek için kullandığı süreçler hakkında bir araştırma raporu yayınladı. Bu da, işleri gizli tutma eğiliminde olan Apple için bir sapmayı temsil ediyor.

Apple, yeni yayınlanan bir araştırma makalesinde Apple Intelligence özelliklerini nasıl geliştirdiğine dair şaşırtıcı miktarda ayrıntıyı açıkladı. Manşet haberi, Apple’ın modellerini eğitmek için Nvidia GPU’ları yerine Google TPU’larını (özellikle TPU v4 ve TPU v5 çiplerini) tercih etmesidir. Bu, OpenAI ve Meta gibi diğer birçok LLM’nin tipik olarak Nvidia GPU’larını kullanması nedeniyle endüstri normlarından bir sapmadır.

Bilmeyenler için, Google, TPU’lara erişimi Google Cloud Platform aracılığıyla satmaktadır. Müşterilerin çipleri kullanabilmeleri için bu platformda yazılım oluşturmaları gerekmektedir.

İşte Apple’ın yaptıklarının bir özeti.

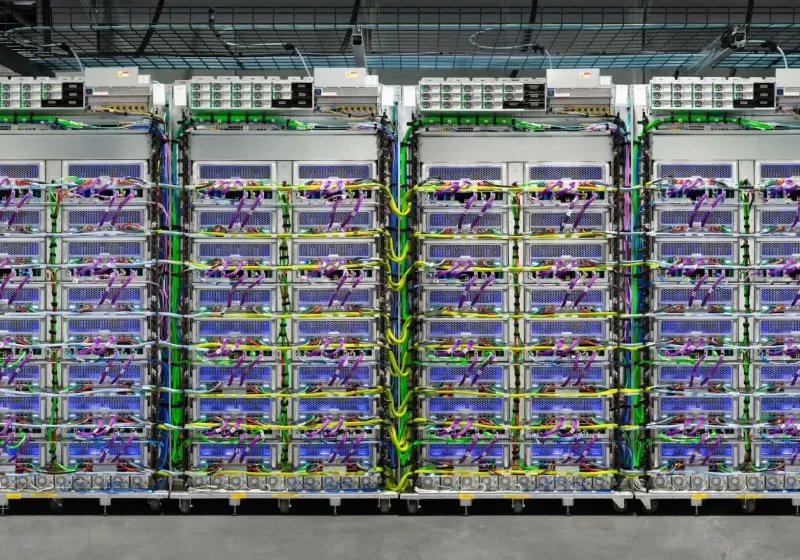

Apple’ın en büyük dil modeli olan AFM sunucusu, her biri 1.024 çipten oluşan 8 dilimde yapılandırılmış 8.192 TPU v4 çip üzerinde eğitildi ve bir veri merkezi ağı üzerinden birbirine bağlandı. AFM sunucusu için eğitim süreci üç aşamadan oluşuyordu: 6,3 trilyon jetonla başlayıp, 1 trilyon jetonla devam etti ve 100 milyar jeton kullanılarak bağlam uzatma ile sonuçlandı.

// İlgili Öyküler

- Google, “sınırlı işlevselliğe” sahip düşük kaliteli Android uygulamalarını yakında kaldırmaya hazırlanıyor

- Apple Intelligence AI’nın piyasaya sürülmesi ertelenirken, Samsung Galaxy AI’nın 200 milyon cihaza yaklaştığını iddia ediyor

Sunucu modelinin budanmış bir versiyonu olan AFM-on-device modeli, 6,4 milyar parametreli sunucu modelinden 3 milyar parametreli bir modele damıtıldı. Bu cihaz üstü model, 2.048 TPUv5p çip kümesinde eğitildi.

Apple, robots.txt’ye bağlı kalarak Applebot web tarayıcısından veri kullandı ve çeşitli lisanslı yüksek kaliteli veri kümeleriyle birlikte. Ek olarak, seçilmiş kod, matematik ve genel veri kümeleri kullanıldı.

Apple’ın kendi iç testlerine göre, hem AFM sunucu hem de AFM cihaz modelleri kıyaslamalarda iyi performans gösterdi.

Dikkat çekici birkaç şey var. Birincisi, araştırma makalesindeki detaylı açıklama, genellikle şeffaflığıyla tanınmayan bir şirket olan Apple için dikkate değer. Yapay zekadaki ilerlemelerini sergilemek için önemli bir çaba gösterdiğini gösteriyor.

İki, Google TPU’larını seçme kararı anlamlıydı. Nvidia GPU’ları AI eğitimi için aşırı yüksek talep görüyordu ve arzı azdı. Google’ın muhtemelen Apple’ın AI gelişimini hızlandırmak için hızlıca erişebileceği TPU’ların daha acil kullanılabilirliği vardı ve bu zaten pazara geç geldi.

Ayrıca okuyun: Apple Intelligence AI’nın piyasaya sürülmesi ertelendi, bu arada Samsung, Galaxy AI’nın 200 milyon cihaza yaklaştığını iddia ediyor

Apple’ın Google’ın TPU v4 ve TPU v5 yongalarının LLM’lerini eğitmek için gerekli hesaplama gücünü sağladığını bulması da ilgi çekicidir. AFM sunucu modelinin eğitildiği 8.192 TPU v4 yongası, bu iş yükü için Nvidia’nın H100 GPU’larına benzer performans sunuyor gibi görünüyor.

Ayrıca, diğer birçok şirket gibi Apple da şu anda AI çip pazarına hakim olan Nvidia’ya aşırı bağımlı olmaktan çekiniyor. Teknoloji yığınını kontrol etme konusunda titiz olan bir şirket için Google ile devam etme kararı özellikle mantıklı.